Lorsque l’on aborde le domaine de l’interaction homme-machine (IHM), en particulier avec les assistants personnels, il est important de prendre en compte une dimension plus « relationnelle ». Les différentes technologies de reconnaissance vocale, parmi de nombreuses autres innovations, améliorent constamment leurs fonctionnalités pour favoriser leur adoption par le public. Ainsi, parler à un assistant vocal devrait être aussi naturel que de parler à un humain. C’est à partir de ce constat que nous allons vous présenter ce que nous, et de nombreux experts, considérons comme l’un des éléments essentiels de ces nouvelles technologies : la reconnaissance des émotions.

La reconnaissance des émotions, la prochaine étape dans la relation homme-machine.

Aujourd’hui, les assistants vocaux, comme d’autres technologies dans ce domaine, gagnent du terrain auprès de différents publics cibles. Grâce à de nombreuses fonctionnalités qui, par nature, sont plus faciles et plus intuitives pour l’utilisateur, ces nouveaux outils passent du statut de « Nice-To-Have » à celui de véritable « Must-Have » dans de nombreux domaines. Cependant, selon Sophie Kleber, directrice exécutive de Huge, cela est loin d’être suffisant pour libérer tout le potentiel de la conversation homme/machine.

Dans une conférence intitulée « Designing emotionally intelligent machines« , elle présente sa vision de l’avènement du mode d’interaction vocale, tout en précisant que celui-ci sera associé à l’émergence de l’informatique affective. C’est-à-dire que pour créer des relations fortes avec les humains, les systèmes devront être capables de reconnaître, d’interpréter, d’utiliser et de simuler les émotions.

Cette vision est également partagée par de nombreux spécialistes du domaine, dont Viktor Rogzik, chercheur à la division Alexa Speech Group d’Amazon : « La reconnaissance émotionnelle est un sujet de recherche de plus en plus populaire dans le domaine de l’intelligence artificielle dédiée à la conversation. Le développement de la technologie vocale impliquera inévitablement la dimension émotionnelle, les premiers travaux dans ce domaine ont déjà été réalisés, mais ce qui constitue l’état de l’art a encore un long chemin à parcourir. Nous expliquons pourquoi.

L’émotion, pourquoi est-elle si difficile à exploiter ?

Comme pour de nombreuses technologies cognitives (basées sur le fonctionnement du cerveau humain), il est très difficile de reproduire efficacement certains processus complexes. En effet, la langue et l’interprétation sont deux domaines qui présentent d’innombrables exceptions et particularités. Par exemple, l’ironie ou d’autres artifices stylistiques tels que les euphémismes modifient le sens réel d’une phrase et nécessitent une interprétation très contextuelle. Ainsi, les micro-expressions, les modulations de la voix, etc. sont autant d’éléments à prendre en compte pour saisir pleinement les intentions, conscientes ou non, des utilisateurs. Il faut comprendre dans ce sens que se baser uniquement sur les mots est une très grosse erreur, celle commise dans les premiers travaux sur le sujet (où un simple coefficient positif ou négatif était attribué selon le sens des mots).

Il existe également d’autres obstacles tels que :

- Les émotions sont subjectives, leur interprétation peut varier considérablement. Il est en effet très difficile de définir réellement une émotion.

- Que faut-il prendre en compte pour la reconnaissance d’une émotion ? La signification d’un seul mot, d’un ensemble de mots ou d’une conversation entière ?

- La collecte de données est très compliquée. Il y en a beaucoup, voire énormément, et pourtant il est difficile de trouver des données fiables sur les émotions. Par exemple, le journal télévisé est présenté de manière neutre qui n’offre pas de données traitables, les acteurs imitent les émotions ce qui crée un biais dans l’identification.

Comment tirer profit de la reconnaissance des émotions ?

C’est sûrement la partie qui vous intéresse le plus, et la plus pragmatique ! Tout d’abord, c’est une caractéristique qui devrait être essentielle pour l’avenir des assistants vocaux ! « Nous pensons qu’à l’avenir, tous nos utilisateurs voudront interagir avec les assistants de manière émotionnelle. C’est la tendance que nous voyons à long terme », a déclaré Felix Zhang, vice-président du génie logiciel chez Huawei, CNBC.

Demain, il sera possible de coupler des moteurs de parole et d’émotion (STE) avec des systèmes de compréhension et de traitement du langage naturel (NLP) pour identifier et interpréter les émotions dans une conversation ou un discours. Cela ouvre un très large champ d’applications ! Par exemple, il sera possible de personnaliser davantage les services offerts à l’utilisateur en fonction des émotions qu’il ressent. Quelle meilleure façon d’améliorer l’expérience que d’adapter le résultat en fonction de ce que l’utilisateur ressent ?

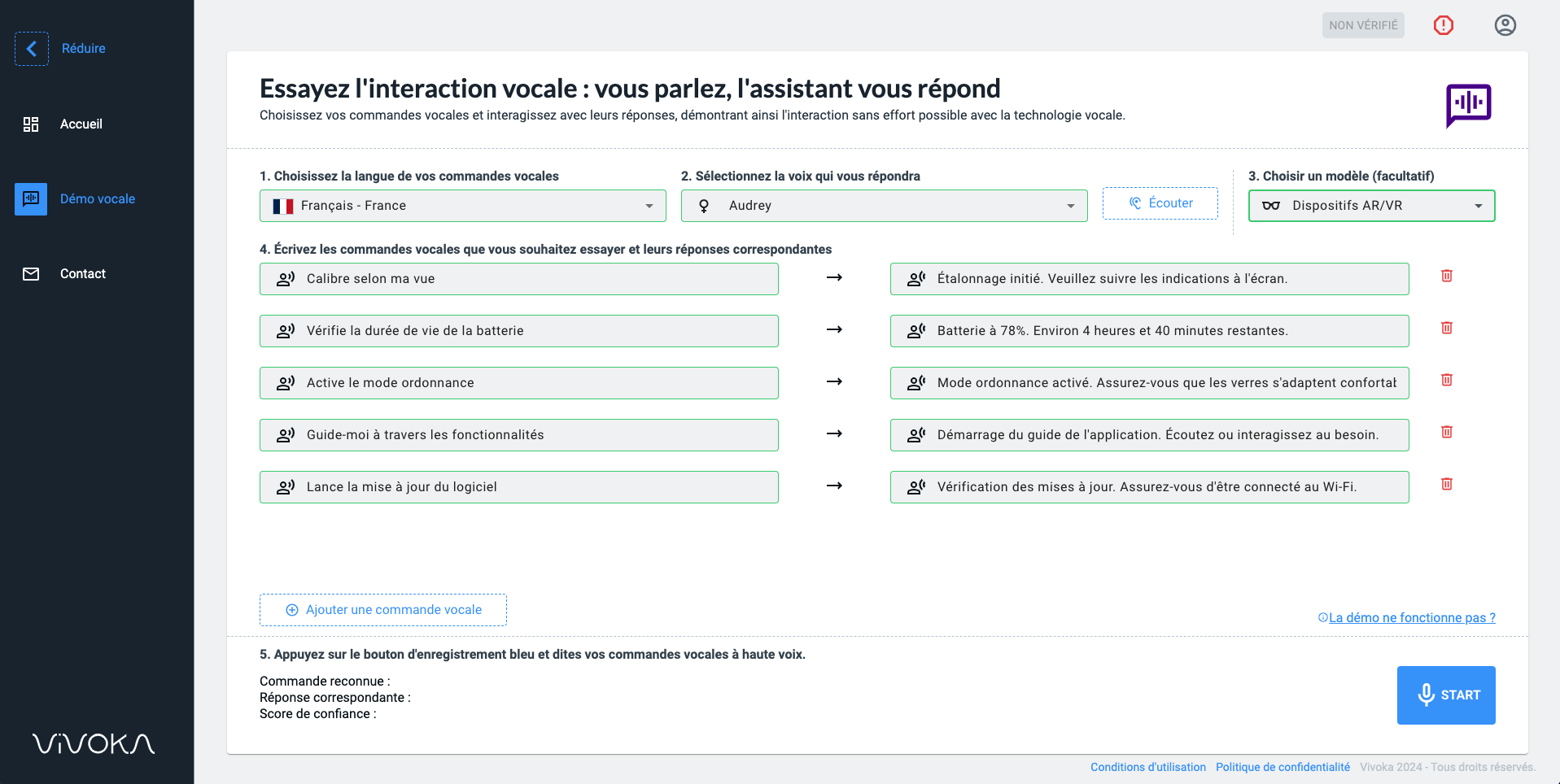

Nous parlons beaucoup de ce que la voix peut offrir en termes d’expérience. Pour exploiter cette dimension, il n’y a pas que la voix de l’utilisateur. Connaissez-vous le TTS (Text-To-Speech) ? Ce sont des moteurs de synthèse vocale qui permettent de créer des voix quasi humaines à partir de textes. La voix de la SNCF ou de la RATP vient de là ! Pour faire un lien avec ce que nous disions avant, l’utilisation d’un TTS personnalisé en fonction de l’émotion identifiée est une piste supplémentaire à une liaison Homme-Machine développée.

L’avenir des systèmes vocaux réside donc dans la reconnaissance des émotions. Ce type d’intelligence émotionnelle est en passe de rapprocher encore plus l’humain de la machine. Cependant, il s’agit encore de la manipulation de données personnelles. Ainsi, le profilage de la voix doit rester en vue d’améliorer l’expérience et de respecter au mieux les lignes directrices du RGPD et les autres principes de protection de la vie privée.