L’IA conversationnelle et documents longs : pourquoi le RAG naïf ne suffit plus

Les grands modèles de langage (LLMs) et l’IA générative s’imposent progressivement comme de véritables leviers de performance pour les professionnels. Aujourd’hui, certaines entreprises les utilisent pour automatiser les réponses aux clients. D’autres s’en servent comme outil d’aide au diagnostic des pannes. Les LLM sont également sollicités dans le cadre d’analyses financières notamment pour résumer des rapports complexes. En pratique, les LLM aujourd’hui améliorent l’efficacité, la compréhension des tâches, et accélèrent également la prise de décision dans le milieu.

Cependant, le recours exclusif aux LLM reste une approche limitée. Plus les documents sont longs et techniques, plus la probabilité d’erreurs augmente. En outre, les entreprises sont confrontées à plusieurs contraintes : la pertinence des informations, la sécurité des données, la latence des réponses et le coût d’inférence.

La génération augmentée par récupération (RAG) répond à ce besoin en extrayant des données contextuelles spécifiques pour fournir des réponses précises.

IA conversationnelle et documents longs : pourquoi le RAG naïf ne suffit plus

Les grands modèles de langage (LLMs) et l’IA générative s’imposent progressivement comme de véritables leviers de performance pour les professionnels. Aujourd’hui, certaines entreprises les utilisent pour automatiser les réponses aux clients. D’autres s’en servent comme outil d’aide au diagnostic des pannes. Les LLM sont également sollicités dans le cadre d’analyses financières notamment pour résumer des rapports complexes. En pratique, les LLM aujourd’hui améliorent l’efficacité, la compréhension des tâches, et accélèrent également la prise de décision dans le milieu.

Cependant, le recours exclusif aux LLM reste une approche limitée. Plus les documents sont longs et techniques, plus la probabilité d’erreurs augmente. En outre, les entreprises sont confrontées à plusieurs contraintes : la pertinence des informations, la sécurité des données, la latence des réponses et le coût d’inférence.

La génération augmentée par récupération (RAG) répond à ce besoin en extrayant des données contextuelles spécifiques pour fournir des réponses précises.

L’illusion du « tout-contexte » : plus d’information ne veut pas dire meilleure réponse.

Les derniers modèles de langage, GPT-4o, Gemini 2.0 Pro, Claude 3.5, Llama 4, peuvent traiter jusqu’à 10 millions de tokens. De quoi faire croire qu’il suffirait de leur fournir toute une base documentaire interne pour qu’ils répondent avec précision à n’importe quelle question.

Le problème du « needle-in-the-haystack »

Cependant, en pratique, ces modèles se heurtent au problème du “needle-in-the-haystack” : plus la quantité de texte à traiter est grande, plus la réponse risque d’être diluée, mal interprétée, voire perdue dans le texte. Le résultat ? Des réponses floues, incomplètes ou erronées.

Ce phénomène, appelé « needle-in-the-haystack », est mis en évidence par les études BabiLong et NoLIMA, qui montrent qu’en pratique, seuls 10 à 20 % du contexte sont réellement exploités lorsque les informations nécessaires à la réponse sont dispersées.

Illustration tirée de l’étude Babilong

Pour des réponses précises, il faut dépasser la logique de surcharge et mettre en place un mécanisme de recherche ciblée d’informations/connaissances, capable d’identifier uniquement les informations pertinentes selon le contexte de la question.

Traçabilité et vérifiabilité : répondre, c’est aussi citer ses sources

L’un des défauts des LLM lorsqu’ils sont alimentés avec des documents entiers sans sélection préalable est leur opacité. Il devient impossible de savoir d’où vient l’information et de vérifier si elle est fiable, ou s’il s’agit d’une “hallucination”.

Motivation RAG

La RAG change la donne : plutôt que de laisser un modèle de langage naviguer à l’aveugle dans l’ensemble d’un document, elle l’oriente vers les passages qui comptent vraiment. Le procédé est simple : le texte est d’abord converti puis découpé en morceaux — phrases, paragraphes ou sections selon l’approche. Lorsqu’une question est posée, la RAG sélectionne les fragments les plus pertinents, appelés hypothèses. C’est à partir de ces hypothèses, et d’elles seulement, que le modèle construit sa réponse. Résultat : moins de devinettes, plus de précision.

Une étude récente (Beyond Naïve RAG) montre que, lorsqu’un système peut relier chaque réponse à des extraits précis du document, il devient plus fiable, plus transparent et plus facile à auditer. Dans un contexte industriel, cette transparence est un atout majeur : elle renforce la confiance des utilisateurs, facilite la conformité réglementaire et limite les risques d’hallucinations.

Coûts d’inférence et scalabilité

Alimenter un modèle avec un document entier augmente mécaniquement la taille du prompt… et donc le coût de l’inférence pour chaque question. Plus il y a de tokens à traiter, plus la réponse est lente et chère à produire.

Face à des centaines de documents non structurés, cette méthode ne suit plus le rythme. Le RAG permet de traiter seulement ce qui compte, au bon moment — pour des réponses plus rapides, moins coûteuses et mieux justifiées.

Modularité et débogage

Un LLM à long contexte fonctionne comme une boîte noire : il traite un bloc de texte, et génère une réponse sans possibilité d’analyser ce qu’il s’est passé entre les deux comme le ferait un humain.

Le RAG introduit une modularité structurante. Chaque étape (recherche, filtrage, réponse) peut être diagnostiquée, mesurée et ajustée indépendamment. Cette séparation des composants facilite le débogage, l’adaptation/ajustement, et l’amélioration continue du système.

Contraintes réglementaires et respect de la confidentialité

Injecter des documents confidentiels dans un LLM est risqué : le modèle ignore les permissions. Le RAG, intégré à des systèmes comme AuthZ, permet de transmettre uniquement les fragments pertinents et accessibles à chaque utilisateur.

Résultat : un meilleur traitement des données, une protection efficace des contenus sensibles, et des réponses pertinentes… sans compromettre la sécurité.

Cependant, répondre à ces exigences suppose que le système RAG filtre, structure et sécurise efficacement l’information avant de la transmettre au LLM optimisant ainsi à la fois la précision, l’efficacité et le contrôle.

Les limites du RAG naïf dans les cas réels

Les premières implémentations du RAG suivent une logique simple : découper les documents en fragments, convertir ces morceaux en vecteurs contextuels (souvent connus par vecteur embeddings) des représentations numériques qui capturent leurs sens), puis les sauvegarder dans une base vectorielle. Lorsqu’une requête est soumise, elle est également convertie en vecteur d’embeddings , puis comparée aux fragments existants selon leurs similarités (souvent via la distance cosinus).

Si les premières implémentations du RAG fonctionnent pour des questions simples, elles échouent dès que l’information est dispersée dans le document. C’est également le cas lorsqu’il s’agit d’une question dont la réponse est construite en plusieurs itérations, ou qui nécessite un raisonnement complexe. Les requêtes professionnelles sont souvent incomplètes ou ambiguës, et difficiles à traiter sans RAG .

Les approches avancées comme HiRAG (recherche hiérarchique), le Chunk-Interaction Graph (prise en compte de la structure), ou GraphRAG/LightRAG (représentation des relations sémantiques) répondent précisément à ce défi : elles maintiennent les liens entre les fragments, facilitant ainsi un raisonnement contextualisé.

Exemple de dépendances inter-fragments

Prenons un cas concret : une requête liée à la surchauffe d’un compresseur. Un système RAG naïf extrait uniquement les passages mentionnant l’entretien du flux d’air, sans comprendre qu’un ventilateur d’évaporateur défectueux peut être le lien critique entre un problème de flux d’air et une surchauffe. Résultat : une réponse partielle ou hors sujet.

En revanche, un RAG avancé maintient les liens entre les fragments. Il comprend, par exemple, que le ventilateur joue un rôle de passerelle logique entre deux fragments de texte — un problème de flux d’air et une surchauffe — ce qui permet de relier correctement les informations et de fournir une réponse juste.

En pratique, ces dépendances peuvent refléter des relations spécifiques au domaine : hiérarchies d’équipements dans la maintenance, enchaînements procéduraux dans la conformité réglementaire, ou dépendances contractuelles en finance.

Modéliser ces relations, notamment en domaines de spécialité, permet de personnaliser la récupération d’information pour assurer de meilleures réponses en cas d’usage réel.

Le défi du raisonnement en plusieurs étapes

Habituellement, répondre aux questions métier ne se réduit pas à copier-coller les informations. Cela nécessite une recherche guidée, structurée en plusieurs étapes.

Multi-hop et multi-part queries : raisonner par étapes, relier plusieurs questions

Certaines questions exigent un raisonnement à plusieurs étapes : par exemple, pour connaître la température maximale d’un générateur de secours, il faut d’abord identifier le site ayant la plus grande capacité électrique, puis accéder aux spécifications techniques de l’équipement en question.

Les systèmes “naïfs”, qui traitent cette requête comme une simple recherche directe, passent souvent à côté des éléments clés et retournent des réponses incomplètes.

Pour y remédier, des méthodes avancées comme ResP (Retrieve, Summarize, Plan) ou Generate-then-Ground permettent de décomposer la question en plusieurs sous-questions, de raisonner étape par étape, et de vérifier la cohérence de chaque réponse intermédiaire.

D’autres approches comme End-to-End Beam Retrieval explorent plusieurs chemins de raisonnement simultanément, afin de maximiser la fiabilité des réponses.

Les nouvelles approches — ResP, Generate-then-Ground, Beam Retrieval — se penchent dessus également. Elles décomposent les questions complexes en sous-questions, déroulent un raisonnement par étapes, et ouvrent la voie à des assistants capables d’un vrai dialogue analytique.

Requêtes conversationnelles : une mémoire à reconstruire

- Mémoire conversationnelle : suivre le fil

Les utilisateurs ne posent pas leurs questions de façon isolée. Ils reformulent, enchaînent, ou reviennent sur des points évoqués plus tôt. Deux grandes approches permettent de gérer ce contexte. - Conversational Dense Retrieval (CDR)

Ces systèmes, entraînés de bout en bout, exploitent à la fois la question actuelle ainsi que l’historique du dialogue. Ils s’appuient sur des modèles (Transformers) comme BERT pour relier les échanges, mais leur opacité complique davantage l’explication des résultats. - Conversational Query Reformulation (CQR)

Cette approche reformule la dernière question pour la rendre autonome (auto-suffisante), à l’aide de modèles spécialisés ou via du prompting. Plus simple à intégrer, elle reste toutefois moins optimisée que le CDR en termes de performance.

L’ambiguïté : l’obstacle le plus humain

Sur le terrain , les professionnels auront tendance à poser des questions vagues ou incomplètes.

Les systèmes RAG naïfs, qui s’appuient uniquement sur la question , peinent à gérer cette ambiguïté. Ils récupèrent des fragments de texte approximatifs, sans tenir compte du contexte ou de la logique métier.

Les approches avancées vont plus loin : elles détectent le manque d’information et génèrent des questions de clarification. Certaines s’appuient sur des graphes de connaissances pour anticiper les besoins métiers ; d’autres utilisent un prompting progressif pour affiner la compréhension.

L’objectif ici est de faire en sorte que le système sache, lui aussi, poser les bonnes questions.

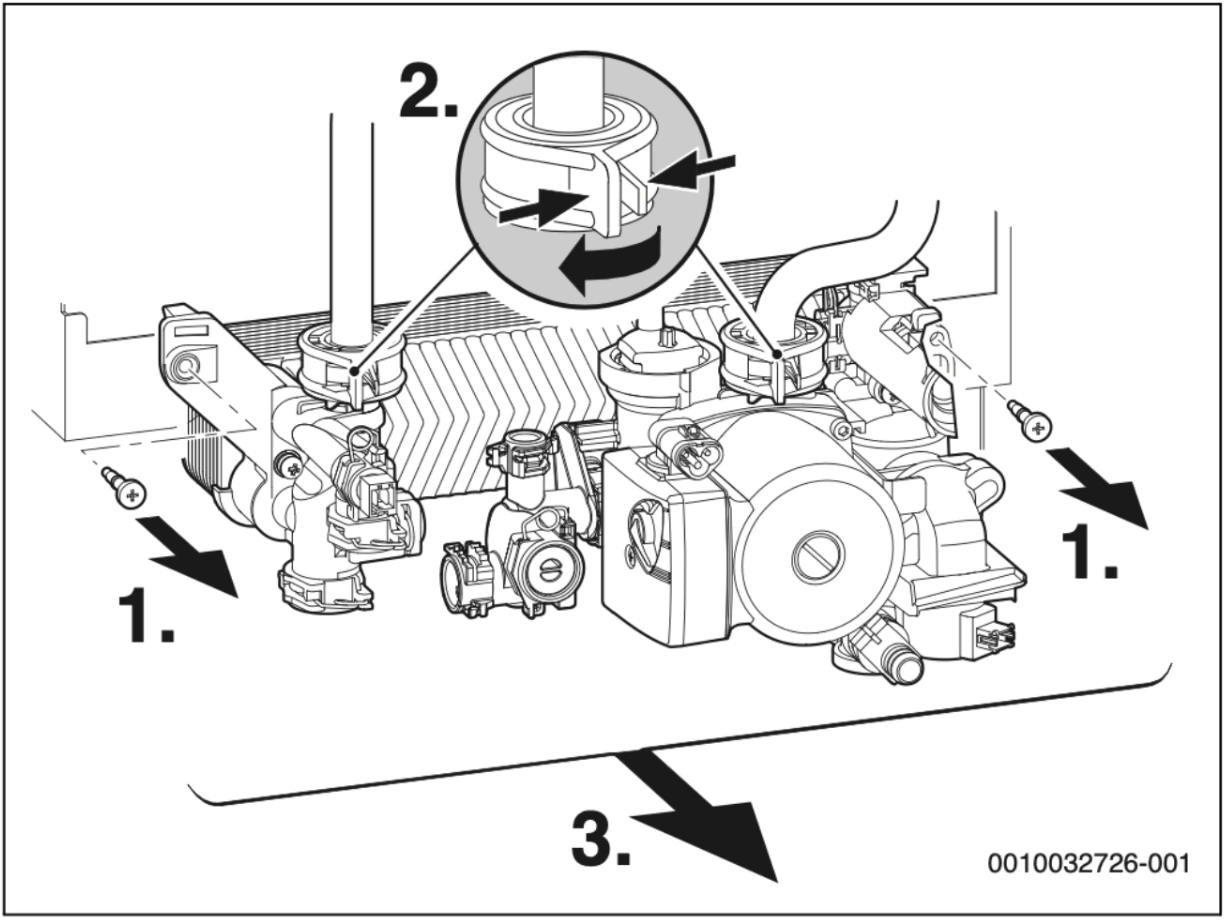

Quand le texte ne suffit pas : la dimension multimodale

Schémas, tableaux, plans, images annotées… ce sont des repères essentiels dans les documents métiers. Si on les met de côté, on perd une partie cruciale de l’information.

Schéma de l’unité de pompe d’une chaudière (extrait d’un manuel Bosch)

Les modèles comme CLIP, MM-EMBED, ou Qwen-VL permettent désormais de créer des vecteurs d’embeddings partagés (text-image), représentant à la fois textes et images. Les données visuelles peuvent alors être interprétées, et intégrées au texte pour fournir des réponses complètes et contextualisées.

Cette nouvelle représentation marque une évolution : de la recherche augmentée, nous entrons dans l’ère de la compréhension augmentée.

Une IA qui cherche mieux

Cet article révèle que l’avenir de l’IA conversationnelle ne réside pas toujours dans des modèles plus vastes, ni dans des fenêtres de contexte toujours plus longues. La qualité de la sélection des extraits de texte, la richesse des liens entre eux, et la finesse du raisonnement sont tout autant importants.

Chez Vivoka, c’est cette vision que nous concrétisons. En croisant expertise et innovations en structuration de la recherche, nous développons des assistants capables de s’adapter à la vraie complexité des métiers et aux exigences professionnelles.

Des IA précises, adaptées, prêtes à l’usage.

Dans le monde professionnel, l’exactitude n’est pas un avantage secondaire : c’est une exigence.