L’Homme n’a jamais cessé de rêver de communiquer avec la machine. Cependant, jusqu’à ces dernières années, l’interaction homme-machine a longtemps été très limitée et peu naturelle pour l’utilisateur. Heureusement, les progrès récents en matière de matériel informatique et de logiciels de système ont permis de communiquer plus naturellement avec les machines, comme on peut le faire aujourd’hui avec ChatGPT. C’est grâce au traitement du langage naturel (NLP) que de nombreux systèmes comme ce dernier ont atteint ce niveau. Dans cet article, nous expliquerons comment fonctionne le NLP et où vous pouvez le trouver.

Qu’est-ce que le traitement du langage naturel ?

Le traitement du langage naturel se situe à l’intersection de l’intelligence artificielle et de la linguistique. Il s’agit de la technologie permettant aux ordinateurs d’imiter le comportement humain en matière de communication (parler, écouter, lire, comprendre, etc.). Alors que les ordinateurs comprendraient mal les phrases prononcées, le traitement du langage naturel permet d’ajouter un sens (ou une signification) aux mots et aux phrases. Cela permet aux ordinateurs de communiquer de manière plus pertinente avec les utilisateurs, ce qui ouvre la voie à plusieurs applications, telles que les IA conversationnelles.

Niveaux de traitement du langage naturel

L’ordinateur doit être capable de comprendre les déclarations et de les interpréter comme le ferait un être humain. Des années de recherche dans ce domaine ont permis de développer un schéma général de traitement. Il comprend plusieurs étapes qui doivent être suivies dans l’ordre pour pouvoir interpréter correctement le langage humain. En effet, tout comme les humains, l’ordinateur devra déterminer le début et la fin d’une phrase, avant de commencer à analyser les différents mots qui la composent et traiter le sens global de la phrase en fonction du contexte. Cela permet à la machine de décomposer les éléments textuels ou vocaux afin d’en extraire le sens. Traditionnellement, il existe plusieurs niveaux de traitement dans le traitement du langage naturel, nous allons nous plonger dans les principaux.

Traitement lexical

Le traitement lexical consiste à analyser la structure d’une phrase en se basant sur des règles de surface (ce que l’on voit), comme les majuscules qui impliquent le début d’une phrase ou un nom propre, le point en fin de phrase et ainsi de suite… en utilisant la méthode du « sac de mots ». Le processus qui permet à l’ordinateur de distinguer les mots ou groupes de mots et leur nature dans une phrase est appelé « tokenisation ».

Il consiste à étiqueter chaque token avec des « tags » pour l’identifier dans l’une des différentes catégories grammaticales :

- Pronom ;

- Verbe conjugué au présent ;

- COD ;

- … et ainsi de suite pour chaque élément de la phrase.

A l’issue de cette étape, nous disposons de tous les éléments pour caractériser chacun des mots en fonction de leur nature et de leur rôle dans l’ensemble.

Prenons un exemple. Si l’entrée est : « La femme porte des baskets Nike ».

Alors nous devrions avoir comme résultat :

- « La » = article défini qui commence la phrase (reconnu grâce à la majuscule)

- « femme » = nom commun ;

- « porte » = verbe conjugué au présent ;

- « Nike » = nom propre (reconnu grâce à la majuscule) ;

- « baskets » = nom commun, terminant la phrase par un point.

Niveau syntaxique

Ce niveau traite de la grammaire. En effet, il faut déterminer ce qui constitue la phrase et si les éléments sont grammaticalement corrects, afin de pouvoir en comprendre le sens.

Avec cette décomposition, chaque groupe de mots de la phrase est isolé et identifié. La validation de la syntaxe est possible en définissant à l’avance les différentes structures qu’elle peut adopter. Il s’agit de quelque chose de difficile à définir en raison des nombreuses ambiguïtés possibles. Par exemple : « Je veux manger et dormir toute la journée » → manger toute la journée, dormir toute la journée, ou les deux ?

Dans l’exemple précédent, la sortie doit valider le groupe de mots et le fait qu’il est grammaticalement correct :

- Le fait que « la femme porte des baskets » et non l’inverse est correct ;

- Nike est la marque des baskets qu’elle porte.

Niveau sémantique

Il complète les analyses lexicale et syntaxique qui lui ont permis d’obtenir une phrase interprétable. C’est le niveau qui traite de la sémantique : c’est là que l’ordinateur donne un sens et un contexte à la phrase pour la comprendre dans son ensemble. Le résultat est une modélisation du sens. C’est la partie traitée par la compréhension du langage naturel, nous vous suggérons de lire notre article sur le sujet afin d’en avoir une vision précise.

Chaque niveau de traitement du langage naturel est dépendant du précédent. Cela signifie qu’un système ne pourrait pas comprendre correctement la sémantique sans avoir validé au préalable le niveau syntaxique et le traitement lexical.

Génération de langage naturel

La génération de langage naturel permet de produire des sorties écrites ou orales naturelles. Il s’agit d’un sous-ensemble du NLP dans le sens où il est capable de parler (ou d’écrire, vous avez compris), mais pas de lire ou de comprendre. Elle nécessite donc les étapes précédentes du traitement du langage naturel, qui analyse les phrases et en comprend le sens, les intentions et les entités : la compréhension du langage naturel. La génération du langage naturel est assurée par la synthèse vocale, dans l’ensemble de technologies du VDK.

Exemples d’applications du traitement du langage naturel

Détection des spams

Un exemple courant que vous ne soupçonnez peut-être pas est celui des filtres de courrier électronique. Ceux qui sauvent votre boîte aux lettres électronique de milliers de messages indésirables voire dangereux. Il s’agit d’un filtre bayésien, car il utilise la logique bayésienne pour évaluer l’en-tête et le contenu d’un courrier électronique et pour déterminer la probabilité qu’il s’agisse d’un spam. Il l’explore et le compare au contenu souvent présent dans les courriers indésirables. Un exemple de tous les jours, mais tout le monde n’en est pas conscient.

Sachez qu’il n’est pas seulement utilisé pour les messages de spam ! Par exemple, Gmail dispose d’un système de classification qui permet de trier les courriels en fonction de l’objet du contenu (social, promotions, etc.).

Analyse des sentiments

L’analyse des sentiments est un processus basé sur le traitement du langage naturel utilisé pour déterminer si un retour d’information est positif ou non. Cette technologie permet d’analyser les courriels ou de faire de l’écoute sociale et d’exploiter des données textuelles telles que les idées ou les tendances des clients pour savoir quels aspects méritent d’être mis en avant et quelles sont les caractéristiques ou les aspects qui méritent une attention ou des améliorations.

Résultats du moteur de recherche

Le « RankBrain » de Google est un algorithme dont la mission est de comprendre les demandes de recherche des utilisateurs et d’analyser la façon dont ils réagissent à ces résultats. Le traitement du langage naturel en fait partie et permet à Google de comprendre ce que les gens veulent dire. Par exemple, lorsque quelqu’un cherche « la console noire développée par Microsoft », le premier résultat est la dernière Xbox.

Il y a quelques années, RankBrain parcourait les sites web afin de trouver le(s) mot(s) clé(s) recherché(s) par l’utilisateur et de l’afficher comme l’un des résultats de la page de résultats.

Aujourd’hui, l’algorithme de Google utilise le traitement du langage naturel comme l’un des composants pour afficher les pages susceptibles de correspondre à la requête. Ensuite, il vérifie si c’est le cas en observant le taux de clics, le temps de séjour et le taux de rebond (et bien d’autres indicateurs).

C’est comme lorsque vous cherchez un mot ou une expression dans un dictionnaire. Vous pouvez soit taper les lettres l’une après l’autre pour composer le mot que vous cherchez, soit chercher un sens. Qui n’a jamais cherché un mot précis qu’il avait oublié en tapant sa signification ?

Traduction

La traduction linguistique est un exemple populaire pour la plupart des gens. En effet, il s’agit probablement de l’une des premières applications du traitement du langage naturel dans l’histoire, Georgetown et IBM ayant présenté leur première machine de traduction NLP dans les années 1950. À l’époque, cette machine était capable de traduire une soixantaine de phrases du russe vers l’anglais grâce à une combinaison de linguistique, de statistiques et de règles linguistiques. Le traitement du langage naturel est important ici pour interpréter précisément un message ET déterminer l’équivalence dans une langue étrangère présentant des particularités similaires.

Cependant, même s’il s’agit de l’un des exemples les plus évidents dans l’esprit des gens, ce n’est pas l’application la plus évidente à réaliser pour cette technologie. En effet, elle doit comprendre parfaitement le contexte afin de fournir une traduction correcte. De nos jours, les machines à traduire ne traduisent plus mot à mot. Cela rend la traduction beaucoup plus précise, mais nécessite beaucoup de traitement.

Les Chatbots et assistants intelligents

Les chatbots basés sur le NLP permettent des réponses plus précises grâce à l’interprétation de l’intention des utilisateurs et se basent sur l’intelligence artificielle pour déterminer la réponse la plus appropriée. Il en va de même pour les assistants intelligents tels que Siri, Alexa ou Google Assistant. Ces derniers sont devenus de véritables assistants capables de créer et d’éditer des listes de courses, d’acheter quelque chose pour vous, etc. Nous vous conseillons de lire notre article de blog sur l’expérience utilisateur vocale pour avoir un aperçu des meilleures pratiques dans la conception d’un assistant intelligent !

Limites

Le traitement du langage naturel est une solution puissante, mais elle n’est pas sans limites. Comme vous pouvez l’imaginer, plusieurs éléments font qu’il est difficile pour une machine de comprendre et de parler parfaitement le langage naturel.

Ambiguïté

L’ambiguïté du langage humain peut être difficile à comprendre, parfois même pour les êtres humains. Les systèmes NLP peuvent avoir des difficultés à distinguer les multiples sens d’un même mot ou d’une même phrase, comme dans le cas des homonymes par exemple.

En outre, ces systèmes ne sont pas encore en mesure de saisir toute la finesse du langage. Par exemple, lorsque nous utilisons le sarcasme ou l’ironie pour exprimer le contraire de ce que nous disons. Dès lors, il devient plus complexe pour un ordinateur de comprendre qu’un mot « positif » peut être utilisé pour exprimer un sentiment négatif dans un certain contexte.

Jargon spécifique à un domaine

En fonction de notre culture ou de notre domaine de travail, nous utilisons tous des expressions différentes, un jargon spécifique pour communiquer. Pour comprendre réellement le langage naturel, les machines doivent comprendre les mots couramment utilisés ainsi que les mots plus spécifiques. Cela est possible grâce à l’entraînement et à la mise à jour réguliers des modèles personnalisés. Pour le jargon spécifique à un domaine, il est également possible de s’appuyer sur des modèles spécialement conçus en fonction de la niche.

Langues à faibles ressources

Les langues à faibles ressources désignent les langues qui disposent de moins de données pour entraîner les systèmes d’IA. Les langues européennes et occidentales sont des langues à hautes ressources, mais plusieurs d’entre elles disposent de très peu de données. Toutes les langues africaines ou certaines langues d’Europe de l’Est comme le biélorusse, par exemple. Il est donc plus difficile d’entraîner les modèles à comprendre correctement ces langues. Même avec l’aide de nouvelles techniques telles que les transformateurs multilingues et l’intégration de phrases multilingues, qui sont censées identifier les similitudes universelles dans les différentes langues existantes.

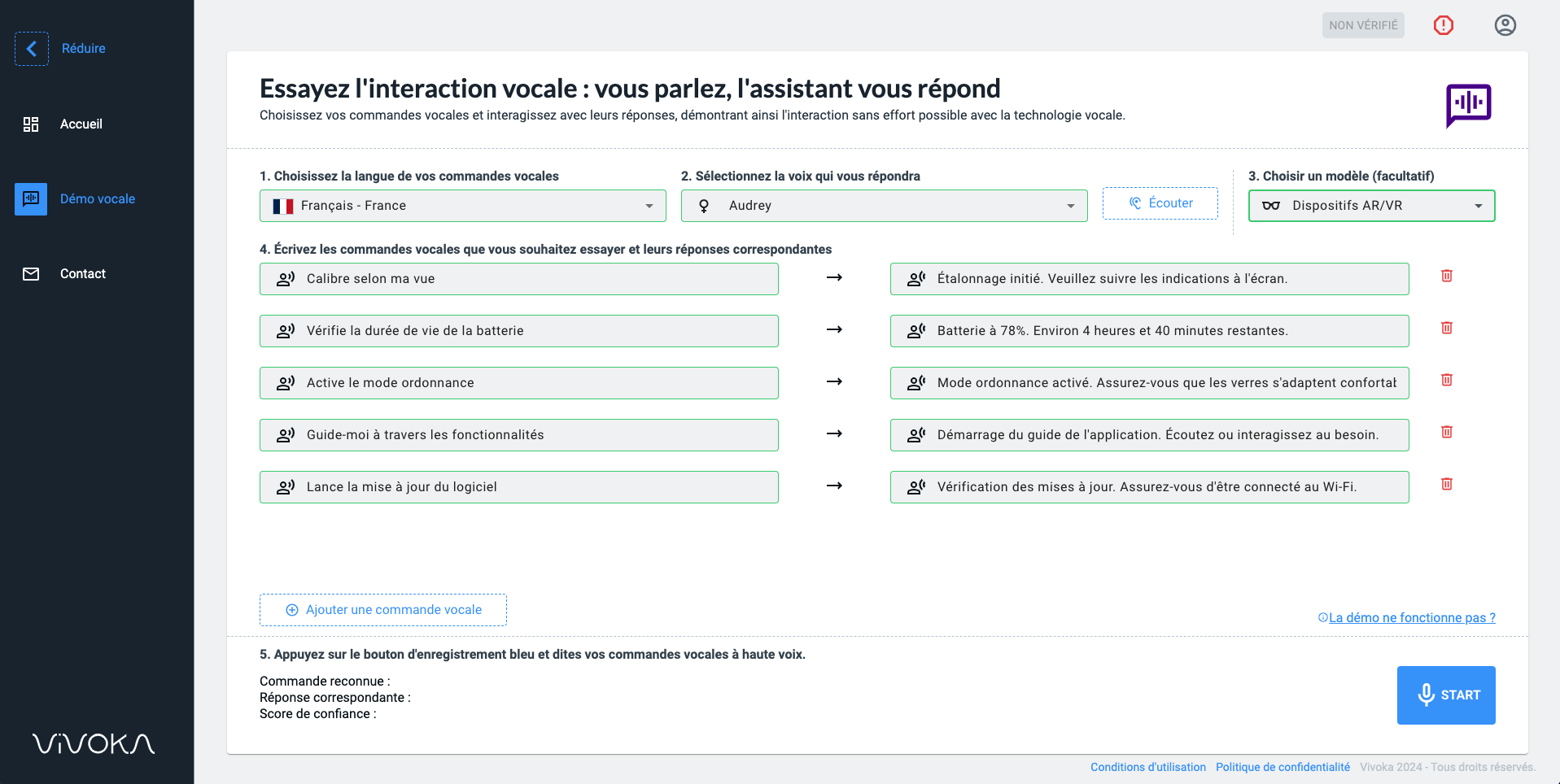

Un système de traitement du langage naturel professionnel

Le traitement du langage naturel existe depuis longtemps et a permis d’énormes avancées dans les sciences informatiques. En effet, les IA conversationnelles actuelles telles que ChatGPT, Siri, Google Assistant et bien d’autres sont toutes capables de répondre à vos questions et s’améliorent chaque jour grâce à la quantité de données qu’elles traitent. Mais le NLP n’est pas seulement conçu pour le cloud. En effet, Vivoka fournit aux entreprises une technologie vocale hors ligne, permettant de construire un système de traitement naturel du langage complètement intégré préservant les données, qu’il s’agisse de celles de vos clients finaux ou de celles de votre personnel. Vous souhaitez créer un assistant vocal personnalisé pour rationaliser vos processus et améliorer votre productivité ? Contactez-nous !